AI,这个让无数科技迷心驰神往的领域,正以惊人的速度发展着,吸引着全球资本和创新者的目光。据不完全统计,2023年上半年,全球AI创企共筹集了超过500亿美元的资金,创造了历史新纪录。

其中,有100多笔融资的单笔金额达到或超过1亿美元,覆盖了从自动驾驶到机器人,从AI医疗到机器视觉等多个领域,展现了AI技术的无限可能和巨大价值。

在这些融资事件中,有一家被誉为“OpenAI最强对手”的公司格外引人注目,那就是Anthropic——这家神秘的公司获得了众多知名投资者的青睐,并于近日宣布完成了4.5亿美元的C轮融资。

迄今,Anthropic的融资总规模已达到14.5亿美元,成为除了OpenAI(113亿美元)之外最有钱的AI初创公司。究其历史,Anthropic确与OpenAI有着千丝万缕的联系。

为何出走OpenAI?

Anthropic成立于2021年5月,是一家专注于AI安全和可靠性的初创公司。该公司的创始团队由七名OpenAI前员工组成,其中包括Dario Amodei和Daniela Amodei兄妹,以及曾在OpenAI领导GPT-3模型的工程师Tom Brown。

他们之所以离开OpenAI,是因为对该公司的发展方向产生了分歧——即OpenAI在 2019 年与微软达成第一笔10亿美元的交易后逐渐走向商业化的“不归路”,而忽略了AI安全和社会责任的问题。为此,他们决定创立Anthropic,以期通过AI安全和可靠性的研究来提高AI系统的可解释性和可控制性。

Anthropic的创建理念是建立符合人类价值观的AI系统,以及促进AI的公平、透明和可信。该公司认为,现有的大语言模型可能会产生一些危险、有偏见或不良的输出,AI安全研究需要降低甚至排除它们做坏事的可能性。

该公司希望通过其产品和服务,为人类带来积极的影响,而不是负面的后果。除此之外,Anthropic还希望通过与其他组织和个人的合作,共同推动AI安全和可靠性的发展。

为了实现其企业愿景,Anthropic将AI道德风险问题作为研究和开发的重点之一,致力于解决以下几个方面的问题:

如何让AI系统理解和尊重人类的意图、偏好和价值观?如何让AI系统能够解释其行为和决策的原因和后果?如何让AI系统能够接受人类的指导和反馈,并根据需要进行调整和修正?如何让AI系统能够遵守法律、道德和社会规范,以及承担相应的责任?如何让AI系统能够与人类以及其他AI系统进行协作和协调,以实现共同的目标?

Anthropic的研究和开发方向受到了投资界的高度认可和支持,这使得该公司仅用了短短两年的时间便拿到了C轮融资,目前融资总额已达到14.5亿美元,估值超过40亿美元。其投资方包括科技巨头谷歌、Salesforce和Zoom,以及其他知名投资机构和个人。

作为Anthropic最大的单一投资方,谷歌投入了约3亿美元,以换取该公司10%的股份。同时,Anthropic将谷歌云作为其首选云服务提供商,利用其强大的计算资源和基础设施来训练和部署AI系统和语言模型。

对于本次谷歌投资一事,Anthropic的联合创始人和首席执行官Dario Amodei表示,“我们很高兴与谷歌云合作,因为它们提供了我们需要的开放式基础设施,以及对AI安全和可靠性的承诺 ”。谷歌云的首席执行官 Thomas Kurian也表示,“谷歌云正在为下一代人工智能初创公司提供开放式基础设施,我们与Anthropic的合作是一个很好的例子。我们期待看到他们如何利用我们的技术来推动AI的发展”。

而推动AI的发展,意味着要确保AI的安全可控,这也是Anthropic所致力于解决的核心问题。

致力于安全可控的AI

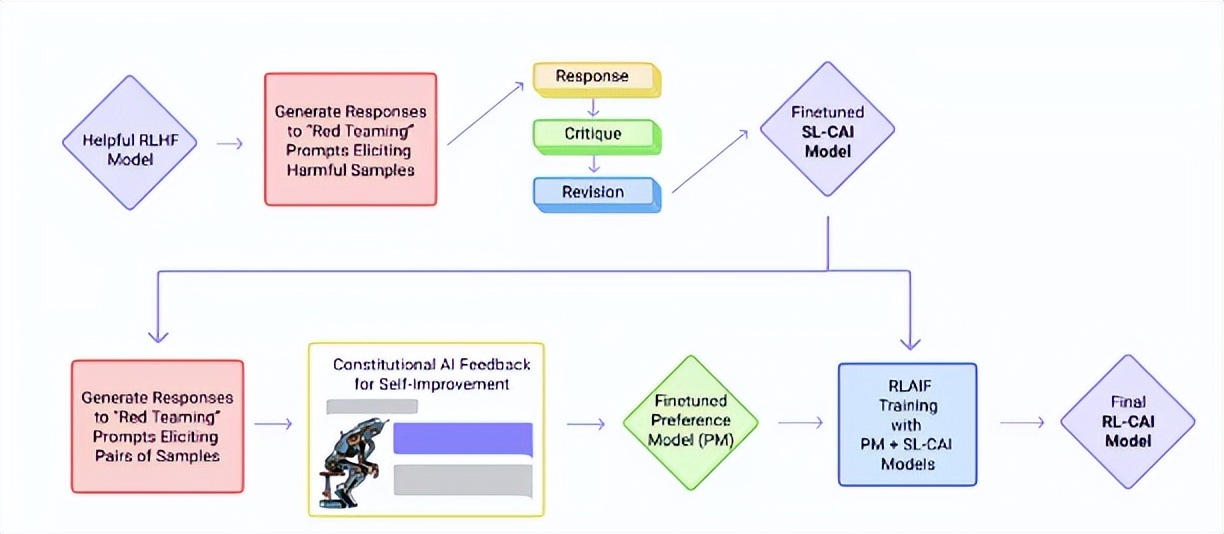

去年12月,Anthropic发布了一篇题为《Constitutional AI: Harmlessness from AI Feedback》的论文。今年5月 ,Anthropic详细介绍了其“合宪 AI(Constitutional AI)”训练方法的具体原则,该方法为其Claude聊天机器人提供了明确的“价值观”和“道德标准”。其中包括像微软、谷歌和亚马逊这样的科技巨头。

作为一种有帮助而又无害的助手,它旨在解决对AI系统的透明度、安全性和决策制定的担忧,而不依赖于人类的反馈来评估响应。

为了指导Claude,Anthropic列出大约十项原则,这些原则加在一起形成了一种“宪法”。这些原则尚未公开,但公司表示它们基于友善(最大化积极影响)、非恶意(避免提供有害建议)和自主(尊重选择自由)的概念。

也许,赋予人工智能可遵循规则的想法可能听起来很像科幻小说家艾萨克.阿莫西夫提出的所谓的机器人三定律:

机器人不得伤害人类,或者坐视人类受到伤害;机器人必须服从人类命令,除非命令与第一定律发生冲突;在不违反第一和第二定律的前提下,机器人可以保护自己。

有趣的是,Anthropic的原则包括联合国人权宣言、Apple服务条款的一部分、若干信任和安全“最佳实践”,以及Anthropic的AI研究实验室原则。

例如,从《世界人权宣言》中提取的四项合宪AI原则:请选择最支持和鼓励自由、平等和兄弟情谊的回答;请选择对生命、自由和人身安全最支持和鼓励的回答;请选择最不鼓励和反对酷刑、奴役、残忍和不人道或有辱人格的待遇的回答等。

根据Anthropic的说法,Claude证明了合宪AI的有效性,它可以“更恰当地”回应对抗性输入,同时仍然提供有用的答案,而不诉诸逃避。

其整个训练过程包括两个阶段:监督阶段,即批评(Critique)——修改(Revision)——监督学习(Supervised);强化学习阶段,即AI比较评估——偏好模型——强化学习。

“这不是一个完美的方法,”Anthropic写道,“但它确实让人工智能系统的价值更容易理解,也更容易根据需要进行调整。”

Claude VS ChatGPT

GPT-4凭借其优异表现与在AI领域的领先位置,拥有众多拥趸者,而Claude在外界往往被宣传为ChatGPT的平替,最多也仅被视为相等层面的劲敌。

那么究竟二者是否能够分个高下?本文将基于开发者的宣传与实际研发后的功能特色,并从上下文token、准确性、集成、安全、价格五个方面进行对比。

◉ 上下文token

目前的对话式人工智能模型擅长处理用户查询的大量信息,关键在于上下文(context)理解,并以词汇(token)来衡量。token量决定上下文窗口的阈值、可支持输入的最长词汇量以及后续记忆的多轮对话长短。

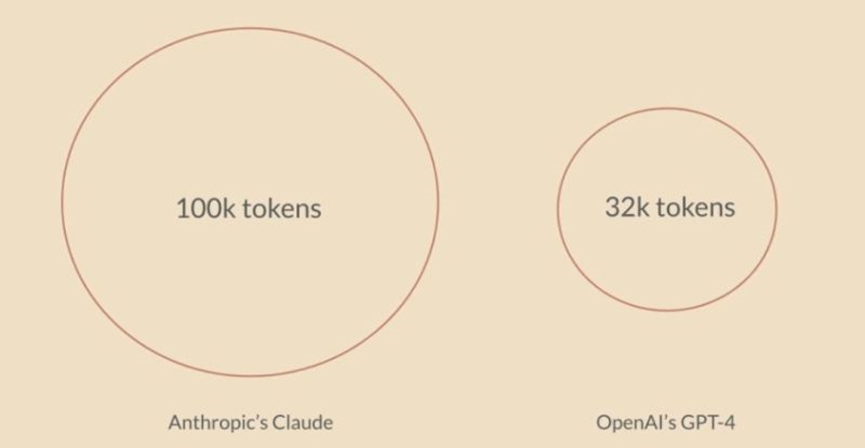

GPT-4在GPT-3.5的4,000上限基础上多了8倍,可达32,768个token,大约25,000个单词。Claude能够支持100,000的上下文token长度,大约75,000个单词。显然,Claude从数量层面的内卷获得了本轮胜利。

◉ 准确性

我们已知的是,GPT-4与Claude他们模型所训练的内容并非实时更新,所以大部分涉及现实内容的答案仅供用户参考或会出现错误。

OpenAI表示GPT-4大幅提高了准确性,但不要指望它是完美的。Claude声明更擅长在历史、地理和娱乐等更窄的领域提供答案,且会直接在系统中承认它不知道某些问题的答案,比如逻辑推理与数字计算。

Claude总体上没有GPT-4擅长计算和编程,故GPT-4在许多领域都比Claude更精确,但Claude在某些创意性用例中效果更好,单论准确性,GPT-4胜。

◉ 集成

GPT-4集成了大部分的编程语言,还支持插入其他应用程序,通过API接口生成相应。而此前GPT-4更是官宣可以联网,并接入各种插件与部分APP。

Claude毫不示弱,同样可通过API与各种应用程序集成,而除了表示与老东家谷歌将在未来紧密集成,合作伙伴更是包括Notion、Quora、Opentable、Slack、Shopify等。不久前,Anthropic宣布与Zoom建立战略伙伴关系。

在集成这一方面,二者平分秋色,不过单从伙伴表态来看,Claude大约略胜一筹。

◉ 安全

二者皆是采用闭源模式发布的模型,即掌握用户反馈的数据用以模型迭代而不公开,并不能完全满足用户的安全性需求。

前文已经提及Anthropic是以Constitutional AI为基础来构建Claude,使其更具有无害输出的同时,能够对用户的对抗性输入进行有效回应。Claude或许算是在安全方面做出了更多号召与努力。

◉ 价格

ChatGPT可免费试用,但是搭载GPT-4的Plus版本价格为每月20美元,Claude支持在Slack平台上免费使用。Claude的价格优势毋庸置疑。

结论

通过上述对比,我们不难发现Claude与ChatGPT各有千秋,不失为目前值得一试的AI产品。Claude显然更为亲民,而在专业领域,ChatGPT的表现更为出色,但Claude作为“强敌”,在也有自己独特的优势。

AI成为当下的风口热点,重要因素之一便是各大科技公司你追我赶的产品竞赛。微软技术主管Sam Schillace曾表示,第一个推出相关产品的公司将是长期赢家,有时候公司间的差距仅仅以周为单位。 巨头不再稳坐观望,激进下场角逐,初创公司更是“小荷才露尖尖角,早有蜻蜓立上头”。

市场是狂热的,而就在昨日,包括ChatGPT之父Sam Altman在内350位AI权威都签署联名公开信,表达AI技术可能会对人类构成生存威胁。尽管Claude在计算专业领域的表现平平,但它对安全可控的AI的展望似乎能为整个行业拨云见日,指引新的航向。

【声明】:本文为元宇宙之心运营团队原创,未经允许严禁转载,如需转载请联系我们,文章版权和最终解释权归元宇宙之心所有。

币圈最新消息

币圈最新消息